Comment optimiser ses prompts (prompt engineering) ?

Pour une IA générative, un prompt est une instruction envoyée en langage naturel à un algorithme d’IA pour générer du contenu (texte, images etc.). À l’image d’une recette de cuisine, un ingrédient en trop ou manquant peut complètement changer la pertinence des réponses générées. Il conviendra dans tous les cas de bien analyser et vérifier la véracité des informations générées.

Il existe plusieurs bonnes pratiques pour optimiser ses prompts (attention : chaque outil aura également ses spécificités et répondra plus ou moins bien à une même instruction). L’outil LMarena ou Compar:IA permet de comparer les réponses à un prompt sur différents modèles simultanément.

S’il fallait ne retenir qu’une première base pour optimiser un prompt, cela peut être le modèle RCTF « Rôle + Contexte + Tâche + Format » :

- R – Rôle : Qui doit être l’IA ? (ex: Juriste, Responsable RH, Guide…) .

- C – Contexte : Quelle est la situation ? (ex: Public étudiant, ton formel, urgence…) .

- T – Tâche : Que doit faire l’IA ? (ex: Rédiger, Résumer, Traduire…) .

- F – Format : Quelle forme doit prendre la réponse ? (ex: Tableau, Mail, Liste à puces…) .

Une fois la réponse générée; si celle-ci n’est pas totalement satisfaisante ou doit être affinée, il sera possible d’interagir / de collaborer avec le modèle pour ajuster / corriger les éléments. Le mode « Canvas » présent sur certains modèles permet aussi l’édition interactive directement depuis l’interface.

Pour aller plus loin

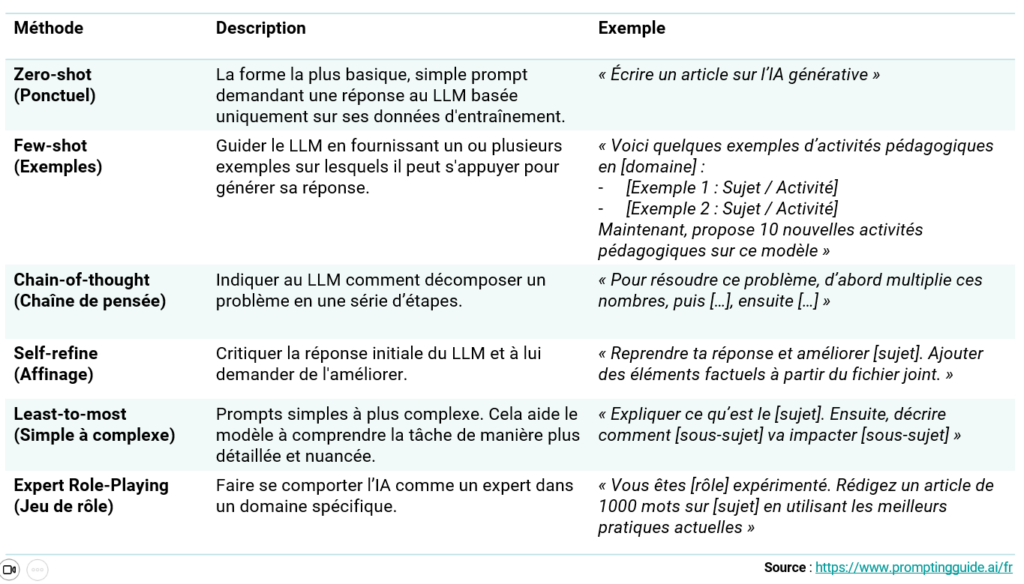

Il existe de multiples méthodes pour adapter ses prompts en fonction de l’usage et l’objectif. Vous retrouverez plusieurs techniques et exemple sur https://www.promptingguide.ai/fr :

Ressources complémentaires

- Prompt Engineering Guide

- L’art du prompt 101 – Guide pour les personnes enseignantes – UQAM/LeCarrefour

- Exemples de prompts pour les enseignants – Wooclap

- Comment prompter en 2024 ? – SIDE Blog – Alain Goudey

- L’art, la technique ou la science du prompt – Bastien Masse

- Guide de OpenAi sur le prompt engineering